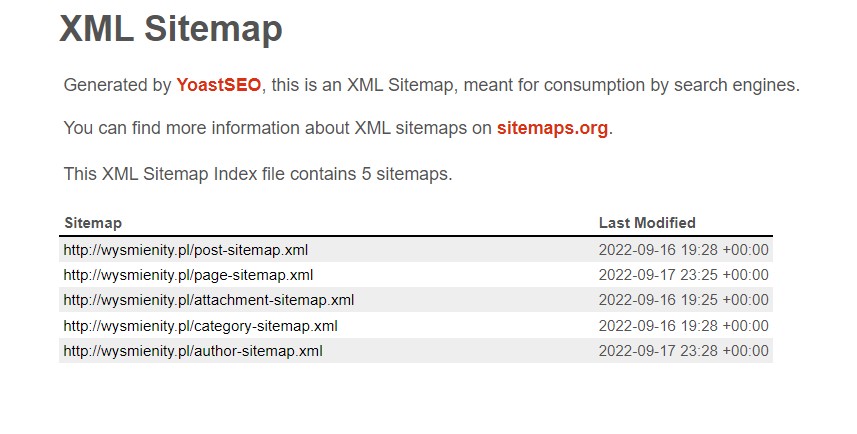

Jednym z najważniejszych adresów, do których powinna odnosić się jedna z dyrektyw zawarta w dokumencie tekstowym robots, jest xml sitemap. Czym jest sitemap? To mapa strony. Mowa o pliku xml, zawierającym wszystkie istotne informacje o podstronach tworzących daną witrynę internetową. Znajdują się tam dane dotyczące dat aktualizacji czy ważności linków.

Należy podkreślić, że sitemap jest plikiem niezwykle przydatnym robotom Google. Dlatego tak ważne jest odniesienie dyrektywy do robots txt sitemap. Powinna to być oczywiście dyrektywa robots allow, zezwalająca na wejście, a nawet sugerująca robotowi, aby przeglądnął mapę w pierwszej kolejności. Dostęp do mapy, która dla robota stanowi bogate źródło informacji, sprawia, że działania Google na stronie trwają krócej, a jednocześnie skanowanie jest inteligentniejsze. Innymi słowy, rośnie prawdopodobieństwo, że robot znajdzie wszystkie istotne informacje, a to skutkuje wyższą pozycją w wynikach wyszukiwania.

Czy warto przygotować plik robots txt?

Robots txt to zagadnienie odnoszące się do zaawansowanego SEO. Niemniej jednak zalecamy, aby skorzystać z pliku naprowadzającego boty, ponieważ wpływa to pozytywnie na działanie strony (zmniejszenie obciążenia serwera) oraz przyczynia się do poprawy pozycji w wynikach wyszukiwań. Posiadamy wiedzę i doświadczenie, dzięki którym szybko i sprawnie przygotowujemy, a w razie potrzeby również aktualizujemy pliki robots txt, w tym robots txt for WordPress.